Создайте собственную систему машинного перевода для любой области и бизнес-задачи

Набор инструментов для машинного перевода

Подготовка данных

Разбор, фильтрация, разметка параллельных и одноязычных корпораций. Создание блоков для тестовых и проверочных данных

Обучение моделей

Обучение пользовательской нейронной архитектуры с параллельными списками заданий, аналитикой на GPU и оценкой качества

Развертывание

По окончании обучения модели она может быть автоматически развернута как API или доступна для загрузки для автономного использования

От новичка до эксперта

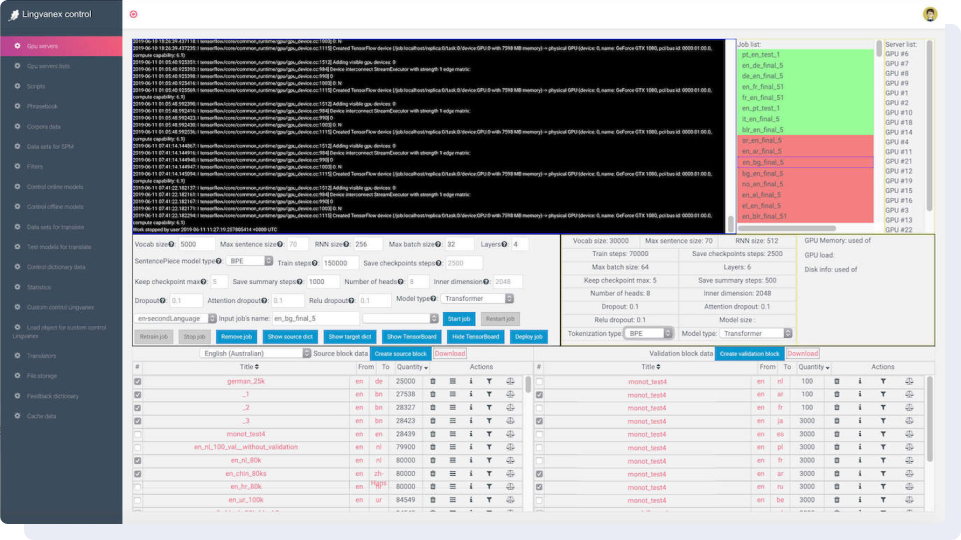

Dashboard сочетает в себе новейшие лингвистические и статистические методы, которые используются для обучения программного обеспечения доменам заказчика и повышения качества перевода. На рисунке ниже: справа – список задач и GPU-серверов, на которых обучаются модели. В центре находятся параметры нейронной сети, а ниже – наборы данных, которые будут использоваться для обучения.

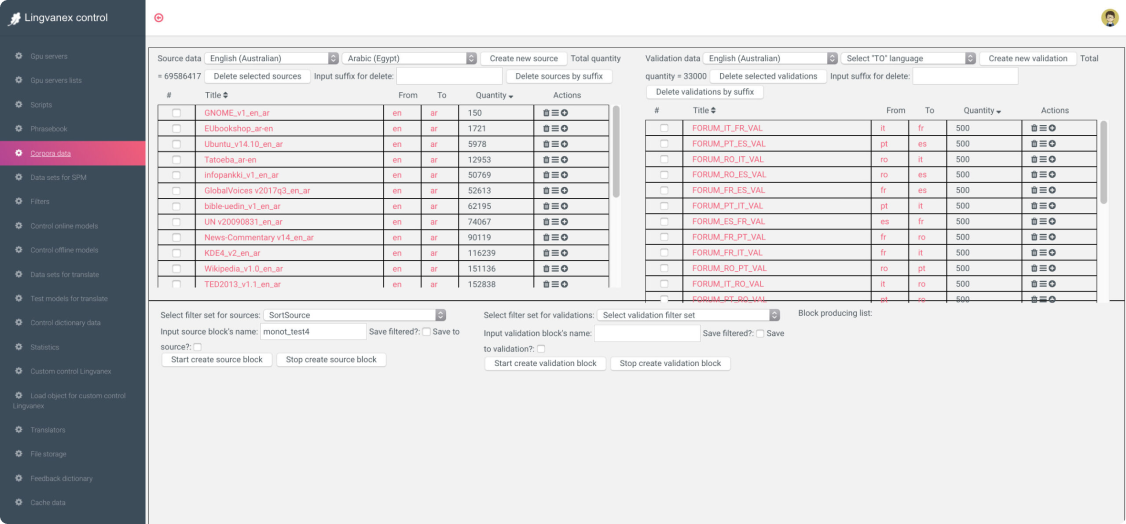

Работа с параллельными данными

Работа над новым языком началась с подготовки наборов данных. Приборная панель имеет множество предопределенных наборов данных из открытых источников, таких как Wikipedia, Европейский парламент, Paracrawl, Tatoeba и другие. Для достижения среднего качества перевода достаточно 5 миллионов строк перевода.

Настройка словаря и токенизатора

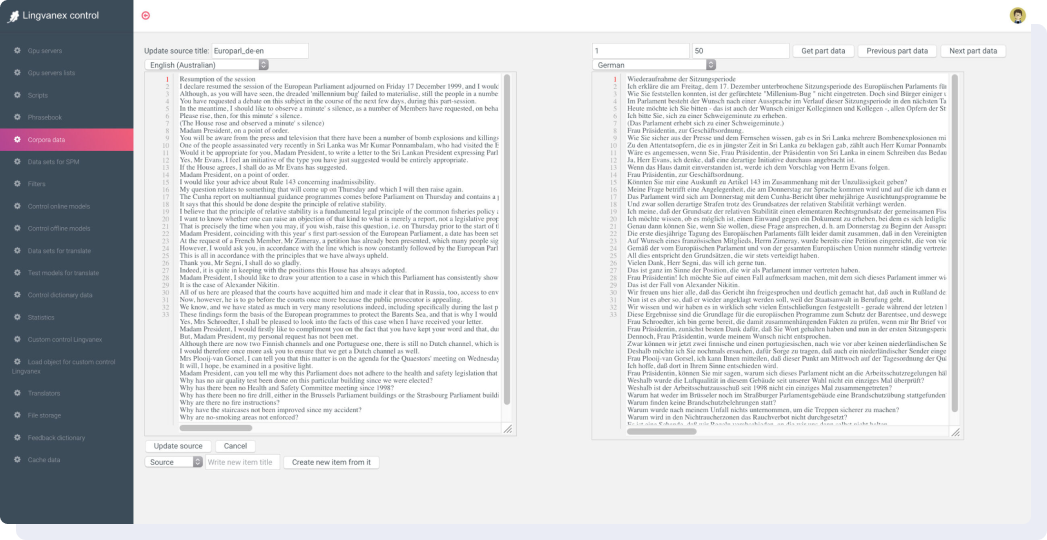

Наборы данных – это строки текста, переведенные с одного языка на другой. Затем токенизатор разбивает текст на лексемы и создает из них словари, отсортированные по частоте встречаемости лексем. Токен может состоять из отдельных символов, слогов или целых слов. С помощью Lingvanex Data Studio вы можете контролировать весь процесс создания словарей лексем SentencePiece для каждого языка отдельно.

Фильтрация данных и оценка качества

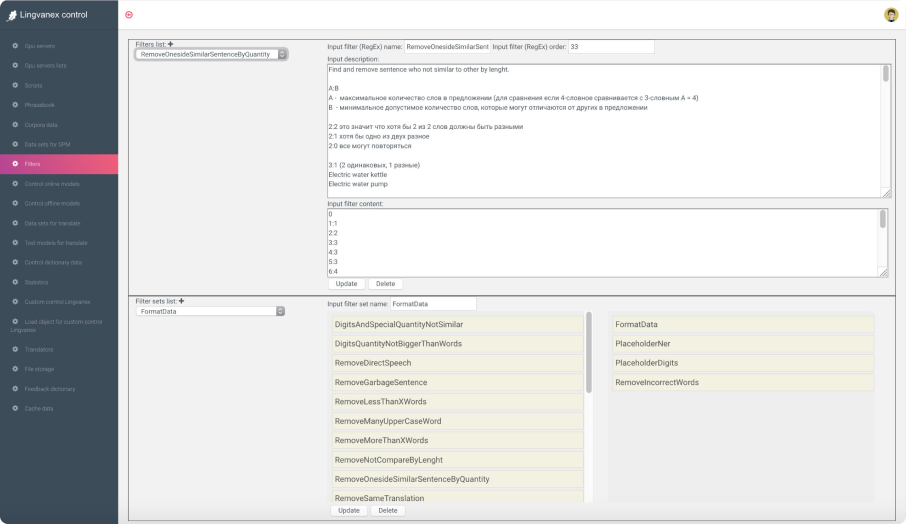

Доступно более 20 фильтров для фильтрации параллельных и одноязычных корпораций, чтобы получить качественный набор данных из открытых источников или разобранных данных. Вы можете разметить именованные объекты, цифры и любые другие токены, чтобы научить систему оставлять некоторые слова непереведенными или переведенными определенным образом.

Свяжитесь с нами сейчас

И получите бесплатный доступ к нашим решениям!