在机器翻译质量评估中,不仅要比较不同翻译系统的结果,还要检查发现的差异是否具有统计显着性。这使我们能够评估所获得的结果是否有效并且可以推广到其他数据。

在本文中,我们回顾了评估翻译质量的两个最常见的指标 BLEU 和 COMET,并分析了如何使用这些指标测试两个翻译系统之间差异的统计显着性。

BLEU 和 COMET 的统计意义

BLEU(双语评估研究)指标通过将翻译文本中的 n 克与参考(人类)翻译中的 n 克进行比较来评估翻译质量。根据研究 “是的,我们需要统计显着性测试”如图所示,为了声称 BLEU 指标比之前的工作有统计学上的显着改善,差异必须大于 1。0 BLEU 分数。如果我们将 “高度显着的”改进视为 “p 值 < 0。001”,则改进必须为 2。0 BLEU 点或更高。

另一种广泛使用的指标 COMET(用于评估翻译的跨语言优化指标)使用机器学习模型来评估与参考翻译相比的翻译质量。1至4分的差异可能在统计上微不足道,即在误差范围内。即使 4。0 COMET 分数的差异也可能微不足道。

这些结果对于机器翻译系统的开发人员具有重要的实际意义。简单地比较数字指标可能会导致有关翻译质量改进的误导性结论。相反,应该进行统计测试来确定观察到的差异是否真正有意义。

选择用于比较翻译系统的度量

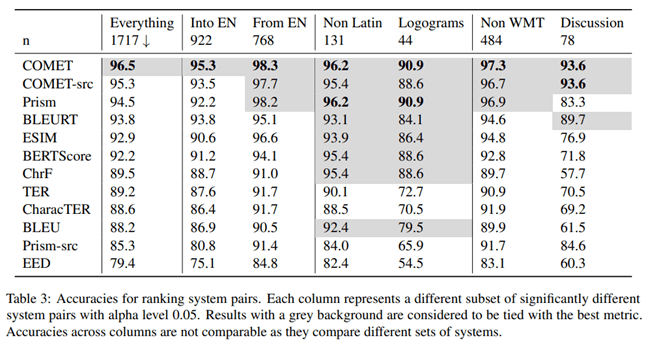

在文章 “到发货还是不发货:机器翻译自动指标的广泛评估”microsoft 的研究人员研究了哪种评估机器翻译质量的指标与专业翻译人员的评估最相关。为此,他们进行了以下实验。

精通目标语言的专业翻译人员首先手动翻译文本,无需后期编辑,然后由独立翻译人员确认这些翻译的质量。译者从其他句子中看到了上下文,但分别翻译了句子。

根据这项研究的结果,根据参考变体评估翻译的 COMET 指标与专业翻译人员的评估相比显示出最高的相关性和准确性。

文章的作者还研究了在比较不同机器翻译系统的质量时哪种指标具有最高的准确性。根据他们的研究结果,COMET 是相互比较翻译系统的最准确指标。

为了测试结果之间差异的统计显着性,作者使用了文章 “机器翻译评估统计显着性测试” 中描述的方法。

显然,COMET 指标是评估机器翻译质量的最可靠工具,无论是在与人工翻译进行比较时还是在相互比较不同的翻译系统时。该结论对于需要客观评估和比较模型性能的机器翻译系统开发人员来说非常重要。

统计显着性检验

重要的是要确保翻译系统之间观察到的差异具有统计显着性,即它们很可能不是随机因素的结果。为此,Philipp Koehn 建议使用他的引导方法 文章 “机器翻译评估的统计显着性测试”。

自举重采样方法是一种基于抽样的统计程序,用于确定样本方差、平均值、标准差、置信区间和样本其他结构特征的样本估计的精度(偏差)。示意性地,引导方法可以表示如下:

用于测试统计显着性的算法:

1。从原始样本中随机生成相同大小的引导样本,其中一些观察结果可能会被捕获多次,而另一些观察结果可能根本不会被捕获。

2锛姣涓涓。量(例如,BLEU或COMET)的平均值,对于每个引导样本进行计算。

3锛屽湪娴欐睙鏉。自举采样和平均值计算过程重复多次(十、百或千)。

4锛姣涓。根据获得的平均值集,计算总体平均值,这被认为是整个样本的平均值。

5锛姣涓。计算比较系统的平均值之间的差异。

6锛夌殑涓€涓。为平均值之间的差异构建置信区间。

7锛屽湪娴欐睙鏉。统计标准用于评估平均值差异的置信区间是否具有统计显着性。

实用应用

Unbabel/COMET库中为COMET度量实现了上述方法,该库除了计算COMET度量之外,还提供了测试所获得结果的统计显着性的能力。这种方法是朝着更可靠和更有效的机器翻译系统评估迈出的重要一步。简单地比较指标通常会产生误导,尤其是当差异很小时。

Bootstrap等统计分析方法的应用是客观评价和比较机器翻译系统性能的重要一步。这使得开发人员在选择最佳方法和模型时能够做出更明智的决策,并向用户提供更可靠的结果呈现。

结论

因此,在比较机器翻译系统时,使用统计方法将有意义的改进与随机因素分开非常重要。这将对机器翻译技术的进展进行更客观的评估。