Na avaliação da qualidade da tradução automática, é importante não apenas comparar os resultados de diferentes sistemas de tradução, mas também verificar se as diferenças encontradas são estatisticamente significativas. Isto permite-nos avaliar se os resultados obtidos são válidos e podem ser generalizados para outros dados.

Neste artigo, revisamos duas das métricas mais comuns para avaliar a qualidade da tradução, BLEU e COMET, e analisamos como testar a significância estatística das diferenças entre dois sistemas de tradução usando essas métricas.

Significado Estatístico de BLEU e COMET

A métrica BLEU (Bilingual Evaluation Understudy) avalia a qualidade da tradução comparando os n-gramas em um texto traduzido com os n-gramas em uma tradução de referência (humana). De acordo com o estudo “Sim, Precisamos de Testes de Significância Estatística”, para reivindicar uma melhoria estatisticamente significativa na métrica BLEU em relação aos trabalhos anteriores, a diferença deve ser superior a 1,0 pontuação BLEU. Se considerarmos uma melhoria “altamente significativa” como “p-valor < 0,001”, a melhoria deve ser de 2,0 pontos BLEU ou superior.

Outra métrica amplamente utilizada, COMET (Métrica Otimizada Translingual para Avaliação de Tradução), utiliza um modelo de aprendizado de máquina para avaliar a qualidade da tradução em comparação com uma tradução de referência. O estudo mostrou que uma diferença de 1 a 4 pontos pode ser estatisticamente insignificante, ou seja, dentro da margem de erro. Mesmo uma diferença de 4,0 pontuações COMET pode ser insignificante.

Estes resultados têm implicações práticas importantes para os desenvolvedores de sistemas de tradução automática. A simples comparação de métricas numéricas pode levar a conclusões enganosas sobre melhorias na qualidade da tradução. Em vez disso, devem ser realizados testes estatísticos para determinar se as diferenças observadas são verdadeiramente significativas.

Selecionando uma métrica para comparação de sistemas de tradução

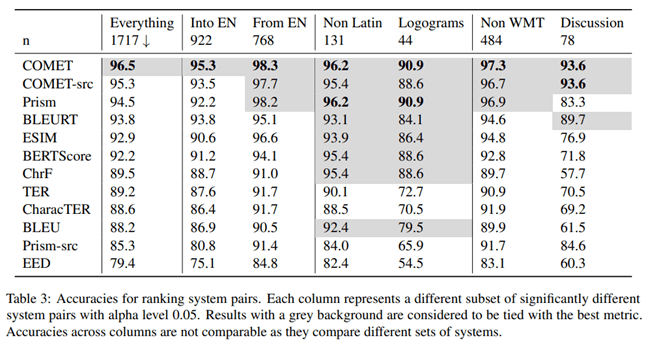

No artigo “Enviar ou Não Enviar: Uma Avaliação Extensa de Métricas Automáticas para Tradução Automática”, pesquisadores da Microsoft investigaram qual métrica para avaliar a qualidade da tradução automática se correlaciona melhor com a avaliação de tradutores profissionais. Para fazer isso, eles conduziram o seguinte experimento.

Tradutores profissionais proficientes no idioma de destino primeiro traduziram o texto manualmente sem pós-edição e, em seguida, um tradutor independente confirmou a qualidade dessas traduções. Os tradutores viram o contexto de outras frases, mas traduziram as frases separadamente.

De acordo com os resultados deste estudo, a métrica COMET, que avalia a tradução com base em uma variante de referência, apresentou a maior correlação e acurácia quando comparada às avaliações de tradutores profissionais.

Os autores do artigo também estudaram qual métrica dá a maior precisão ao comparar a qualidade de diferentes sistemas de tradução automática. De acordo com suas descobertas, COMET é a métrica mais precisa para comparar sistemas de tradução entre si.

Para testar a significância estatística das diferenças entre os resultados, os autores utilizaram a abordagem descrita no artigo “Statistical Significance Tests for Machine Translation Evaluation”.

É claro que a métrica COMET é a ferramenta mais confiável para avaliar a qualidade da tradução automática, tanto ao compará-la com a tradução humana quanto ao comparar diferentes sistemas de tradução entre si. A conclusão é importante para desenvolvedores de sistemas de tradução automática que precisam avaliar e comparar objetivamente o desempenho de seus modelos.

Teste de significância estatística

É importante certificar-se de que as diferenças observadas entre os sistemas de tradução são estatisticamente significativas, ou seja, com uma alta probabilidade de que não sejam o resultado de fatores aleatórios. Para tanto, Philipp Koehn sugere o uso do método bootstrap em seu artigo “Testes Estatísticos de Significância para Avaliação de Tradução Automática”.

O método de reamostragem bootstrap é um procedimento estatístico baseado em amostragem com substituição para determinar a precisão (viés) das estimativas de variância da amostra, média, desvio padrão, intervalos de confiança e outras características estruturais de uma amostra. Esquematicamente, o método bootstrap pode ser representado da seguinte forma:

Um algoritmo para testar a significância estatística:

1. Uma amostra bootstrap do mesmo tamanho é gerada aleatoriamente a partir da amostra original, onde algumas observações podem ser capturadas várias vezes e outras podem não ser capturadas.

2. Para cada amostra de bootstrap, é calculado o valor médio de uma métrica (por exemplo, BLEU ou COMET).

3. O procedimento de amostragem bootstrap e cálculo de médias é repetido muitas vezes (dezenas, centenas ou milhares).

4. A partir do conjunto de médias obtido é calculada a média global, que é considerada a média de toda a amostra.

5. Calcula-se a diferença entre os valores médios para os sistemas comparados.

6. Um intervalo de confiança é construído para a diferença entre as médias.

7. Os critérios estatísticos são utilizados para avaliar se o intervalo de confiança para a diferença de médias é estatisticamente significativo.

Aplicação Prática

A abordagem descrita acima é implementada para a métrica COMET na biblioteca Unbabel/COMET, que, além de calcular a métrica COMET, também fornece a capacidade de testar a significância estatística dos resultados obtidos. Esta abordagem é um passo importante para uma avaliação mais confiável e válida dos sistemas de tradução automática. A simples comparação de métricas muitas vezes pode ser enganosa, especialmente quando as diferenças são pequenas.

A aplicação de métodos de análise estatística, como o bootstrap, é um passo importante na avaliação e comparação objetiva do desempenho de sistemas de tradução automática. Isso permite que os desenvolvedores tomem decisões mais informadas ao selecionar abordagens e modelos ideais e fornece uma apresentação mais confiável dos resultados aos usuários.

Conclusão

Assim, ao comparar sistemas de tradução automática, é importante usar métodos estatísticos para separar melhorias significativas de fatores aleatórios. Isto proporcionará uma avaliação mais objectiva do progresso da tecnologia de tradução automática.