W ocenie jakości tłumaczenia maszynowego ważne jest nie tylko porównanie wyników różnych systemów tłumaczeniowych, ale także sprawdzenie, czy stwierdzone różnice są istotne statystycznie. Pozwala to ocenić, czy uzyskane wyniki są prawidłowe i można je uogólnić na inne dane.

W tym artykule dokonujemy przeglądu dwóch najczęstszych wskaźników oceny jakości tłumaczenia, BLEU i COMET, oraz analizujemy, jak testować istotność statystyczną różnic między dwoma systemami tłumaczenia przy użyciu tych wskaźników.

Znaczenie statystyczne BLEU i COMET

Metryka BLEU (Bilingual Evaluation Understudy) ocenia jakość tłumaczenia poprzez porównanie n-gramów w przetłumaczonym tekście z n-gramami w tłumaczeniu referencyjnym (ludzkim). Według badania “Tak, potrzebujemy badania znaczenia statystycznego”, aby stwierdzić statystycznie istotną poprawę wskaźnika BLEU w porównaniu z poprzednią pracą, różnica musi być większa niż 1,0 wyniku BLEU. Jeśli uznamy poprawę “za bardzo znaczącą” za “wartość p < 0,001”, poprawa musi wynosić 2,0 punktów BLEU lub więcej.

Inna szeroko stosowana metryka, COMET (Crosslingual Optimised Metric for Evaluation of Translation), wykorzystuje model uczenia maszynowego do oceny jakości tłumaczenia w porównaniu z tłumaczeniem referencyjnym. Badanie wykazało, że różnica od 1 do 4 punktów może być nieistotna statystycznie, czyli mieścić się w granicach błędu. Nawet różnica 4,0 punktów COMET może być nieznaczna.

Wyniki te mają ważne implikacje praktyczne dla twórców systemów tłumaczenia maszynowego. Samo porównanie wskaźników liczbowych może prowadzić do mylących wniosków na temat poprawy jakości tłumaczenia. Zamiast tego należy przeprowadzić testy statystyczne w celu ustalenia, czy zaobserwowane różnice są rzeczywiście znaczące.

Wybór metryki do porównywania systemów tłumaczeń

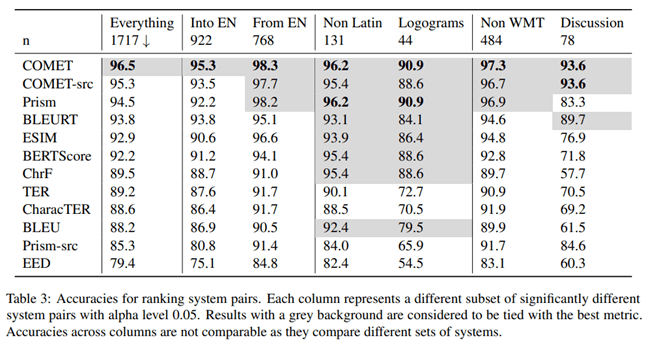

W artykule “To Ship or Not to Ship: An Extensive Evaluation of Automatic Metrics for Machine Tłumaczenie”naukowcy z firmy Microsoft zbadali, która metryka oceny jakości tłumaczenia maszynowego najlepiej koreluje z oceną profesjonalnych tłumaczy. W tym celu przeprowadzili następujący eksperyment.

Profesjonalni tłumacze biegli w języku docelowym najpierw przetłumaczyli tekst ręcznie bez post-edycji, a następnie niezależny tłumacz potwierdził jakość tych tłumaczeń. Tłumacze dostrzegli kontekst z innych zdań, ale przetłumaczyli zdania osobno.

Jak wynika z wyników tego badania, metryka COMET, która ocenia tłumaczenie w oparciu o wariant referencyjny, wykazała najwyższą korelację i dokładność w porównaniu z ocenami dokonywanymi przez profesjonalnych tłumaczy.

Autorzy artykułu badali także, która metryka daje najwyższą dokładność przy porównywaniu jakości różnych systemów tłumaczenia maszynowego. Według ich ustaleń COMET jest najdokładniejszą metryką do porównywania systemów translacji między sobą.

Aby przetestować istotność statystyczną różnic między wynikami, autorzy zastosowali podejście opisane w artykule “Testy istotności statystycznej dla oceny tłumaczenia maszynowego”.

Oczywiste jest, że metryka COMET jest najbardziej niezawodnym narzędziem do oceny jakości tłumaczenia maszynowego, zarówno przy porównywaniu go z tłumaczeniem ludzkim, jak i przy porównywaniu ze sobą różnych systemów tłumaczeń. Wniosek jest ważny dla twórców systemów tłumaczenia maszynowego, którzy muszą obiektywnie ocenić i porównać wydajność swoich modeli.

Statystyczne badanie istotności

Ważne jest, aby upewnić się, że zaobserwowane różnice między systemami translacji są istotne statystycznie, tj. z dużym prawdopodobieństwem, że nie są wynikiem czynników losowych. W tym celu Philipp Koehn sugeruje zastosowanie w swoim projekcie metody bootstrap artykuł “Testy znaczenia statystycznego dla oceny tłumaczenia maszynowego”.

Metoda ponownego próbkowania metodą bootstrap jest procedurą statystyczną opartą na próbkowaniu z zastąpieniem w celu określenia precyzji (odchylenia) szacunków próbki dotyczących wariancji, średniej, odchylenia standardowego, przedziałów ufności i innych cech strukturalnych próbki. Schematycznie metodę bootstrap można przedstawić następująco

Algorytm badania istotności statystycznej:

1. Z próbki pierwotnej generowana jest losowo próbka bootstrap tej samej wielkości, przy czym niektóre obserwacje mogą być rejestrowane kilka razy, a inne w ogóle nie.

2. Dla każdej próbki bootstrap obliczana jest średnia wartość metryki (np. BLEU lub COMET).

3. Procedura pobierania próbek metodą bootstrap i obliczania średnich jest powtarzana wielokrotnie (dziesiątki, setki lub tysiące).

4. Z otrzymanego zbioru średnich obliczana jest średnia ogólna, która jest uważana za średnią całej próby.

5. Obliczana jest różnica pomiędzy średnimi wartościami dla porównywanych układów.

6. Dla różnicy między średnimi konstruowany jest przedział ufności.

7. Kryteria statystyczne służą do oceny, czy przedział ufności dla różnicy średnich jest istotny statystycznie.

Praktyczne zastosowanie

Opisane powyżej podejście zaimplementowano dla metryki COMET w bibliotece Unbabel/COMET, która oprócz obliczenia metryki COMET zapewnia również możliwość testowania istotności statystycznej uzyskanych wyników. Podejście to stanowi ważny krok w kierunku bardziej wiarygodnej i prawidłowej oceny systemów tłumaczenia maszynowego. Samo porównanie wskaźników często może wprowadzać w błąd, zwłaszcza gdy różnice są niewielkie.

Zastosowanie metod analizy statystycznej, takich jak bootstrap, jest ważnym krokiem w obiektywnej ocenie i porównaniu wydajności systemów tłumaczenia maszynowego. Umożliwia to programistom podejmowanie bardziej świadomych decyzji przy wyborze optymalnych podejść i modeli oraz zapewnia bardziej wiarygodną prezentację wyników użytkownikom.

Wniosek

Dlatego porównując systemy tłumaczenia maszynowego, ważne jest, aby stosować metody statystyczne w celu oddzielenia znaczących ulepszeń od czynników losowych. Pozwoli to na bardziej obiektywną ocenę postępu technologii tłumaczenia maszynowego.