Bij de evaluatie van de kwaliteit van automatische vertalingen is het niet alleen belangrijk om de resultaten van verschillende vertaalsystemen te vergelijken, maar ook om te controleren of de gevonden verschillen statistisch significant zijn. Hierdoor kunnen we beoordelen of de verkregen resultaten geldig zijn en kunnen worden gegeneraliseerd naar andere gegevens.

In dit artikel bespreken we twee van de meest voorkomende statistieken voor het beoordelen van de vertaalkwaliteit, BLEU en COMET, en analyseren we hoe we de statistische significantie van verschillen tussen twee vertaalsystemen kunnen testen met behulp van deze statistieken.

Statistische betekenis van BLEU en COMET

De BLEU-metriek (Bilingual Evaluation Understudy) evalueert de vertaalkwaliteit door de n-grammen in een vertaalde tekst te vergelijken met de n-grammen in een (menselijke) referentievertaling. Volgens de studie “Ja, we hebben statistische significantietesting” nodig, om een statistisch significante verbetering van de BLEU-metriek ten opzichte van eerder werk te kunnen claimen, moet het verschil groter zijn dan de 1,0 BLEU-score. Als we een “zeer significante”-verbetering beschouwen als “p-waarde < 0,001”, moet de verbetering 2,0 BLEU-punten of hoger zijn.

Een andere veelgebruikte metriek, COMET (Crosslingual Optimized Metric for Evaluation of Translation), gebruikt een machine learning-model om de kwaliteit van de vertaling te evalueren in vergelijking met een referentievertaling. Uit het onderzoek bleek dat een verschil van 1 tot 4 punten statistisch gezien onbeduidend kan zijn, dus binnen de foutmarge. Zelfs een verschil van 4,0 COMET scores kan onbeduidend zijn.

Deze resultaten hebben belangrijke praktische implicaties voor ontwikkelaars van automatische vertaalsystemen. Het simpelweg vergelijken van numerieke statistieken kan leiden tot misleidende conclusies over verbeteringen in de vertaalkwaliteit. In plaats daarvan moeten statistische tests worden uitgevoerd om te bepalen of de waargenomen verschillen werkelijk betekenisvol zijn.

Een metriek selecteren voor het vergelijken van vertaalsystemen

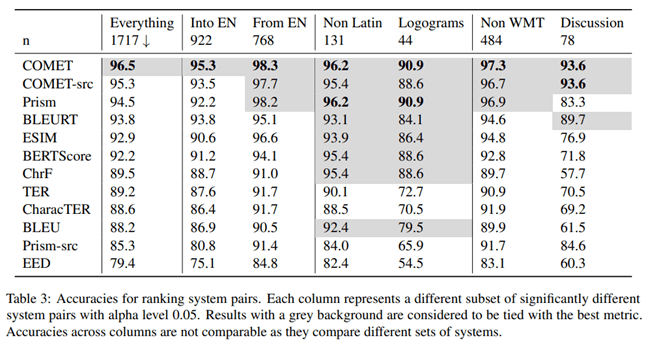

In het artikel“To Ship or Not to Ship: An Extensive Evaluation of Automatic Metrics for Machine Translation”Onderzoekers van Microsoft onderzochten welke maatstaf voor het evalueren van de kwaliteit van automatische vertalingen het beste correleert met de evaluatie van professionele vertalers. Hiervoor voerden ze het volgende experiment uit.

Professionele vertalers die bedreven waren in de doeltaal vertaalden de tekst eerst handmatig zonder nabewerking, en vervolgens bevestigde een onafhankelijke vertaler de kwaliteit van deze vertalingen. De vertalers zagen de context van andere zinnen, maar vertaalden de zinnen apart.

Volgens de resultaten van dit onderzoek vertoonde de COMET-metriek, die vertalingen evalueert op basis van een referentievariant, de hoogste correlatie en nauwkeurigheid in vergelijking met evaluaties door professionele vertalers.

De auteurs van het artikel bestudeerden ook welke metriek de hoogste nauwkeurigheid geeft bij het vergelijken van de kwaliteit van verschillende automatische vertaalsystemen. Volgens hun bevindingen is COMET de meest nauwkeurige maatstaf voor het vergelijken van vertaalsystemen met elkaar.

Om de statistische significantie van verschillen tussen de resultaten te testen, gebruikten de auteurs de aanpak beschreven in het artikel “Statistical Significance Tests for Machine Translation Evaluation”.

Het is duidelijk dat de COMET-metriek het meest betrouwbare hulpmiddel is voor het evalueren van de kwaliteit van automatische vertaling, zowel bij het vergelijken ervan met menselijke vertaling als bij het vergelijken van verschillende vertaalsystemen met elkaar. De conclusie is belangrijk voor ontwikkelaars van automatische vertaalsystemen die de prestaties van hun modellen objectief moeten evalueren en vergelijken.

Statistische betekenistesten

Het is belangrijk om ervoor te zorgen dat de waargenomen verschillen tussen vertaalsystemen statistisch significant zijn, dat wil zeggen met een grote waarschijnlijkheid dat ze niet het resultaat zijn van willekeurige factoren. Voor dit doel stelt Philipp Koehn voor om in zijn werk de bootstrap-methode te gebruiken artikel “Statistische significantietests voor evaluatie van machinevertalingen”.

De bootstrap-resamplingmethode is een statistische procedure gebaseerd op bemonstering met vervanging om de nauwkeurigheid (bias) van steekproefschattingen van variantie, gemiddelde, standaarddeviatie, betrouwbaarheidsintervallen en andere structurele kenmerken van een steekproef te bepalen. Schematisch kan de bootstrapmethode als volgt worden weergegeven

Een algoritme voor het testen van statistische significantie:

1. Een bootstrap-monster van dezelfde grootte wordt willekeurig gegenereerd uit het oorspronkelijke monster, waarbij sommige waarnemingen meerdere keren kunnen worden vastgelegd en andere mogelijk helemaal niet worden vastgelegd.

2. Voor elk bootstrap-monster wordt de gemiddelde waarde van een metriek (bijvoorbeeld BLEU of COMET) berekend.

3. De procedure van bootstrap-bemonstering en berekening van gemiddelden wordt vele malen herhaald (tientallen, honderden of duizenden).

4. Uit de verkregen reeks gemiddelden wordt het algemene gemiddelde berekend, dat wordt beschouwd als het gemiddelde van de gehele steekproef.

5. Het verschil tussen de gemiddelde waarden voor de vergeleken systemen wordt berekend.

6. Voor het verschil tussen de gemiddelden wordt een betrouwbaarheidsinterval geconstrueerd.

7. De statistische criteria worden gebruikt om te beoordelen of het betrouwbaarheidsinterval voor het verschil in gemiddelden statistisch significant is.

Praktische Toepassing

De hierboven beschreven aanpak wordt geïmplementeerd voor de COMET-metriek in de Unbabel/COMET-bibliotheek, die, naast het berekenen van de COMET-metriek, ook de mogelijkheid biedt om de statistische significantie van de verkregen resultaten te testen. Deze aanpak is een belangrijke stap in de richting van een betrouwbaardere en validere evaluatie van automatische vertaalsystemen. Het simpelweg vergelijken van statistieken kan vaak misleidend zijn, vooral als de verschillen klein zijn.

De toepassing van statistische analysemethoden zoals bootstrap is een belangrijke stap in het objectief evalueren en vergelijken van de prestaties van automatische vertaalsystemen. Dit stelt ontwikkelaars in staat om beter geïnformeerde beslissingen te nemen bij het selecteren van optimale benaderingen en modellen, en biedt een betrouwbaardere presentatie van resultaten aan gebruikers.

Conclusie

Bij het vergelijken van automatische vertaalsystemen is het dus belangrijk om statistische methoden te gebruiken om betekenisvolle verbeteringen te scheiden van willekeurige factoren. Dit zal een objectievere beoordeling geven van de vooruitgang van de machinevertaaltechnologie.