機械翻訳の品質評価では、さまざまな翻訳システムの結果を比較するだけでなく、見つかった差異が統計的に有意であるかどうかを確認することも重要です。これにより、得られた結果が有効であり、他のデータに一般化できるかどうかを評価できます。

この記事では、翻訳品質を評価するための最も一般的な 2 つの指標である BLEU と COMET をレビューし、これらの指標を使用して 2 つの翻訳システム間の差異の統計的有意性をテストする方法を分析します。

BLEU と COMET の統計的重要性

BLEU(Bilingual Evaluation Understudy)メトリックは、翻訳されたテキストの n グラムと参照(人間)翻訳の n グラムを比較することによって翻訳の品質を評価します。研究 “によると、はい、統計的有意性テストが必要です”、BLEUメトリックが以前の研究に比べて統計的に有意に改善したと主張するには、その差は1。0 BLEUスコアより大きくなければなりません。“の非常に有意な ” 改善を “p 値 < 0。001” と考える場合、改善は 2。0 BLEU ポイント以上である必要があります。

広く使用されているもう 1 つの指標である COMET(翻訳評価のための相互言語最適化指標)は、機械学習モデルを使用して、参照翻訳と比較して翻訳の品質を評価します。この研究では、1 ~ 4 ポイントの差は統計的に有意ではない、つまり誤差の範囲内である可能性があることが示されました。COMET スコアの差が 4。0 であっても、取るに足らない場合があります。

これらの結果は、機械翻訳システムの開発者にとって重要な実際的な意味を持ちます。数値指標を比較するだけで、翻訳品質の改善に関する誤解を招く結論につながる可能性があります。代わりに、観察された違いが本当に意味があるかどうかを判断するために統計的テストを実行する必要があります。

翻訳システムを比較するための指標の選択

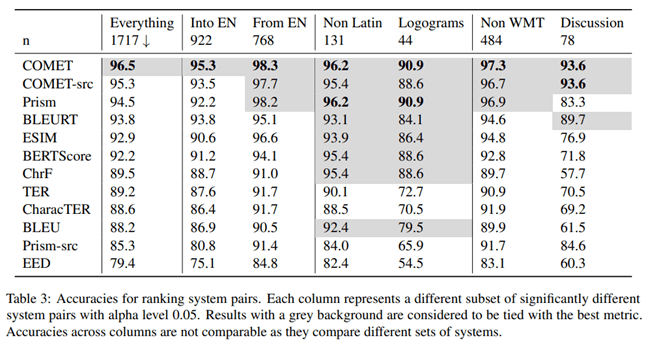

記事内 “発送するかどうか: 機械翻訳の自動メトリクスの広範な評価”、マイクロソフトの研究者は、機械翻訳の品質を評価するためのどの指標がプロの翻訳者の評価と最もよく相関するかを調査しました。そのために、彼らは次の実験を実施しました。

ターゲット言語に堪能なプロの翻訳者が、まずポストエディットなしでテキストを手動で翻訳し、次に独立した翻訳者がこれらの翻訳の品質を確認しました。翻訳者は他の文の文脈を見ましたが、文は別々に翻訳しました。

この研究の結果によると、参照バリアントに基づいて翻訳を評価する COMET メトリックは、プロの翻訳者による評価と比較した場合、最も高い相関関係と精度を示しました。

論文の著者らは、さまざまな機械翻訳システムの品質を比較する際に、どの指標が最も高い精度をもたらすかについても研究しました。彼らの調査結果によると、COMET は翻訳システムを相互に比較するための最も正確な指標です。

結果間の差異の統計的有意性をテストするために、著者らは記事 “機械翻訳評価のための統計的有意性テスト ” に記載されているアプローチを使用しました。

COMET メトリックは、人間の翻訳と比較する場合でも、さまざまな翻訳システムを相互に比較する場合でも、機械翻訳の品質を評価するための最も信頼できるツールであることは明らかです。この結論は、モデルのパフォーマンスを客観的に評価および比較する必要がある機械翻訳システムの開発者にとって重要です。

統計的有意性テスト

翻訳システム間で観察された差異が統計的に有意であること、つまり、ランダムな要因の結果ではない可能性が高いことを確認することが重要です。この目的のために、フィリップ ケーンはブートストラップ法を使用することを提案しています 記事 “機械翻訳評価のための統計的有意性テスト ”。

ブートストラップ リサンプリング法は、サンプルの分散、平均、標準偏差、信頼区間、およびその他の構造特性のサンプル推定値の精度(バイアス)を決定するための、置換を伴うサンプリングに基づく統計手順です。概略的に、ブートストラップ法は次のように表すことができます:

統計的有意性をテストするためのアルゴリズム:

1 を取得します。同じサイズのブートストラップ サンプルが元のサンプルからランダムに生成されます。このサンプルでは、一部の観測値が数回キャプチャされる場合もあれば、他の観測値がまったくキャプチャされない場合もあります。

2 に準拠している。各ブートストラップサンプルについて、メトリクス(例: BLEU または COMET)の平均値が計算されます。

3 に準拠しています。ブートストラップのサンプリングと平均の計算の手順は、何度も(数十、数百、または数千)繰り返されます。

4 に準拠しています。得られた平均セットから全体の平均が計算され、これがサンプル全体の平均とみなされます。

5 に準拠している。比較されたシステムの平均値間の差が計算されます。

6 に準拠している。平均間の差に対して信頼区間が構築されます。

7 に準拠している。統計基準は、平均の差の信頼区間が統計的に有意であるかどうかを評価するために使用されます。

実用的な応用

上で説明したアプローチは、Unbabel/COMET ライブラリ内の COMET メトリックに対して実装されており、COMET メトリックを計算することに加えて、得られた結果の統計的有意性をテストする機能も提供します。このアプローチは、機械翻訳システムのより信頼性が高く有効な評価に向けた重要なステップです。メトリクスを単純に比較することは、特に差が小さい場合、誤解を招くことがよくあります。

ブートストラップなどの統計分析手法の適用は、機械翻訳システムのパフォーマンスを客観的に評価および比較するための重要なステップです。これにより、開発者は最適なアプローチとモデルを選択する際に、より多くの情報に基づいた意思決定を行うことができ、ユーザーにより信頼性の高い結果のプレゼンテーションが提供されます。

結論

したがって、機械翻訳システムを比較するときは、統計的手法を使用して、意味のある改善をランダム要因から分離することが重要です。これにより、機械翻訳技術の進歩をより客観的に評価できるようになります。