Nella valutazione della qualità della traduzione automatica, è importante non solo confrontare i risultati di diversi sistemi di traduzione, ma anche verificare se le differenze riscontrate sono statisticamente significative. Ciò ci consente di valutare se i risultati ottenuti sono validi e possono essere generalizzati ad altri dati.

In questo articolo, esaminiamo due dei parametri più comuni per valutare la qualità della traduzione, BLEU e COMET, e analizziamo come testare la significatività statistica delle differenze tra due sistemi di traduzione utilizzando questi parametri.

Significato statistico di BLEU e COMET

La metrica BLEU (Bilingual Evaluation Understudy) valuta la qualità della traduzione confrontando gli n-grammi in un testo tradotto con gli n-grammi in una traduzione di riferimento (umana). Secondo lo studio “Yes, We Need Statistical Significance Testing”, per ottenere un miglioramento statisticamente significativo nella metrica BLEU rispetto al lavoro precedente, la differenza deve essere maggiore del punteggio BLEU 1,0. Se consideriamo un miglioramento di “altamente significativo” come “valore p < 0,001”, il miglioramento deve essere di 2,0 punti BLEU o superiore.

Un'altra metrica ampiamente utilizzata, COMET (Crosslingual Optimised Metric for Evaluation of Translation), utilizza un modello di apprendimento automatico per valutare la qualità della traduzione rispetto a una traduzione di riferimento. Lo studio ha dimostrato che una differenza da 1 a 4 punti può essere statisticamente insignificante, cioè entro il margine di errore. Anche una differenza di 4,0 punteggi COMET può essere insignificante.

Questi risultati hanno importanti implicazioni pratiche per gli sviluppatori di sistemi di traduzione automatica. Il semplice confronto delle metriche numeriche può portare a conclusioni fuorvianti sui miglioramenti nella qualità della traduzione. Dovrebbero invece essere eseguiti test statistici per determinare se le differenze osservate sono veramente significative.

Selezione di una metrica per confrontare i sistemi di traduzione

Nell'articolo “Spedire o non spedire: una valutazione approfondita delle metriche automatiche per la traduzione automatica”, i ricercatori di Microsoft hanno studiato quale metrica per valutare la qualità della traduzione automatica correla meglio con la valutazione dei traduttori professionisti. Per fare ciò, hanno condotto il seguente esperimento.

Traduttori professionisti esperti nella lingua di destinazione hanno prima tradotto il testo manualmente senza post-editing, quindi un traduttore indipendente ha confermato la qualità di queste traduzioni. I traduttori hanno visto il contesto da altre frasi, ma hanno tradotto le frasi separatamente.

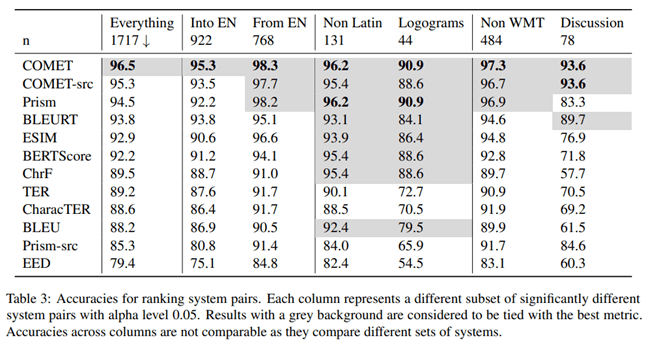

Secondo i risultati di questo studio, la metrica COMET, che valuta la traduzione sulla base di una variante di riferimento, ha mostrato la massima correlazione e accuratezza rispetto alle valutazioni dei traduttori professionisti.

Gli autori dell'articolo hanno anche studiato quale metrica fornisce la massima precisione confrontando la qualità di diversi sistemi di traduzione automatica. Secondo i loro risultati, COMET è la metrica più accurata per confrontare i sistemi di traduzione tra loro.

Per testare la significatività statistica delle differenze tra i risultati, gli autori hanno utilizzato l'approccio descritto nell'articolo “Statistical Significance Tests for Machine Translation Evaluation”.

È chiaro che la metrica COMET è lo strumento più affidabile per valutare la qualità della traduzione automatica, sia quando la si confronta con la traduzione umana, sia quando si confrontano tra loro diversi sistemi di traduzione. La conclusione è importante per gli sviluppatori di sistemi di traduzione automatica che devono valutare e confrontare oggettivamente le prestazioni dei loro modelli.

Test di significatività statistica

È importante assicurarsi che le differenze osservate tra i sistemi di traduzione siano statisticamente significative, vale a dire, con un'alta probabilità che non siano il risultato di fattori casuali. A questo scopo, Philipp Koehn suggerisce di utilizzare il metodo bootstrap nel suo articolo “Test di significatività statistica per la valutazione della traduzione automatica”.

Il metodo di ricampionamento bootstrap è una procedura statistica basata sul campionamento con sostituzione per determinare la precisione (bias) delle stime campionarie di varianza, media, deviazione standard, intervalli di confidenza e altre caratteristiche strutturali di un campione. Schematicamente, il metodo bootstrap può essere rappresentato come segue:

Un algoritmo per testare la significatività statistica:

1. Un campione bootstrap della stessa dimensione viene generato casualmente dal campione originale, dove alcune osservazioni possono essere catturate più volte e altre potrebbero non essere catturate affatto.

2. Per ogni campione di bootstrap, viene calcolato il valore medio di una metrica (ad esempio, BLEU o COMET).

3. La procedura di campionamento bootstrap e calcolo delle medie viene ripetuta molte volte (decine, centinaia o migliaia).

4. Dall'insieme delle medie ottenute viene calcolata la media complessiva, che è considerata la media dell'intero campione.

5. Viene calcolata la differenza tra i valori medi dei sistemi confrontati.

6. Viene costruito un intervallo di confidenza per la differenza tra le medie.

7. I criteri statistici vengono utilizzati per valutare se l'intervallo di confidenza per la differenza delle medie è statisticamente significativo.

Applicazione Pratica

L'approccio sopra descritto è implementato per la metrica COMET nella libreria Unbabel/COMET, che, oltre a calcolare la metrica COMET, fornisce anche la capacità di testare la significatività statistica dei risultati ottenuti. Questo approccio è un passo importante verso una valutazione più affidabile e valida dei sistemi di traduzione automatica. Il semplice confronto delle metriche può spesso essere fuorviante, soprattutto quando le differenze sono piccole.

L'applicazione di metodi di analisi statistica come il bootstrap è un passo importante per valutare e confrontare oggettivamente le prestazioni dei sistemi di traduzione automatica. Ciò consente agli sviluppatori di prendere decisioni più informate quando selezionano approcci e modelli ottimali e fornisce una presentazione più affidabile dei risultati agli utenti.

Conclusione

Pertanto, quando si confrontano i sistemi di traduzione automatica, è importante utilizzare metodi statistici per separare i miglioramenti significativi dai fattori casuali. Ciò fornirà una valutazione più obiettiva del progresso della tecnologia di traduzione automatica.