Buat sistem terjemahan mesin Anda sendiri untuk domain dan tugas bisnis apa pun

Perangkat Penerjemahan Mesin

Persiapan Data

Parse, filter, markup paralel dan korpora monolingual. Buat blok untuk data pengujian dan validasi

Pelatihan Model

Melatih arsitektur neural khusus dengan daftar pekerjaan paralel, analisis GPU, dan estimasi kualitas

Penyebaran

Ketika pelatihan model selesai, model dapat secara otomatis digunakan sebagai API atau tersedia untuk diunduh untuk penggunaan offline

Dari Pemula hingga Ahli

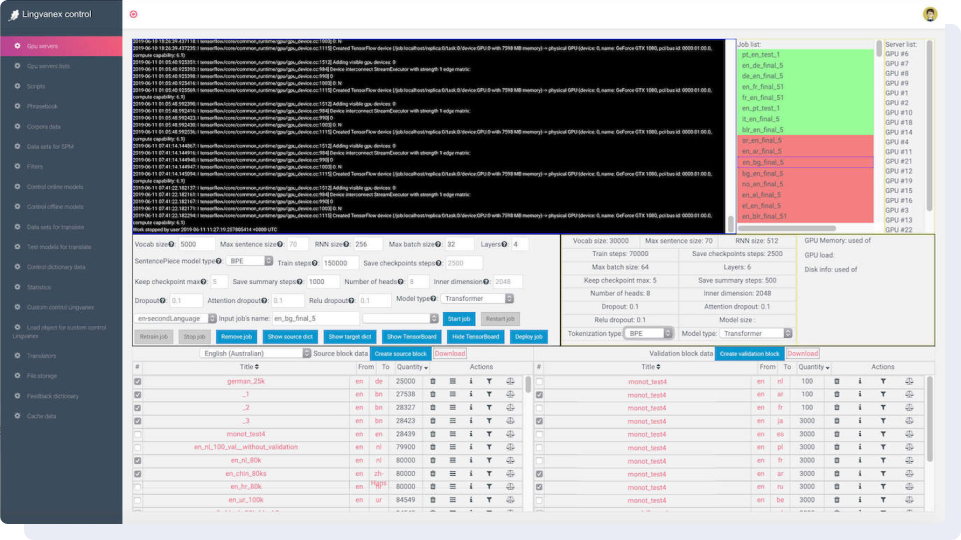

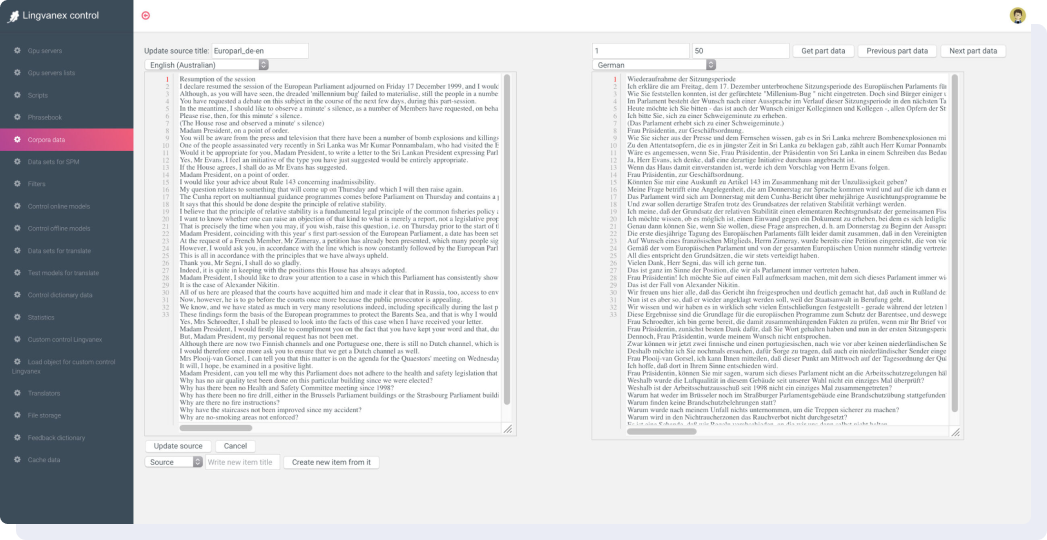

Dashboard menggabungkan teknik linguistik dan statistik terbaru yang digunakan untuk melatih perangkat lunak ke domain pelanggan dan meningkatkan kualitas terjemahan. Pada gambar di bawah ini: di sebelah kanan adalah daftar tugas dan server GPU tempat model sedang dilatih. Di tengah adalah parameter jaringan saraf, dan di bawah ini adalah dataset yang akan digunakan untuk pelatihan.

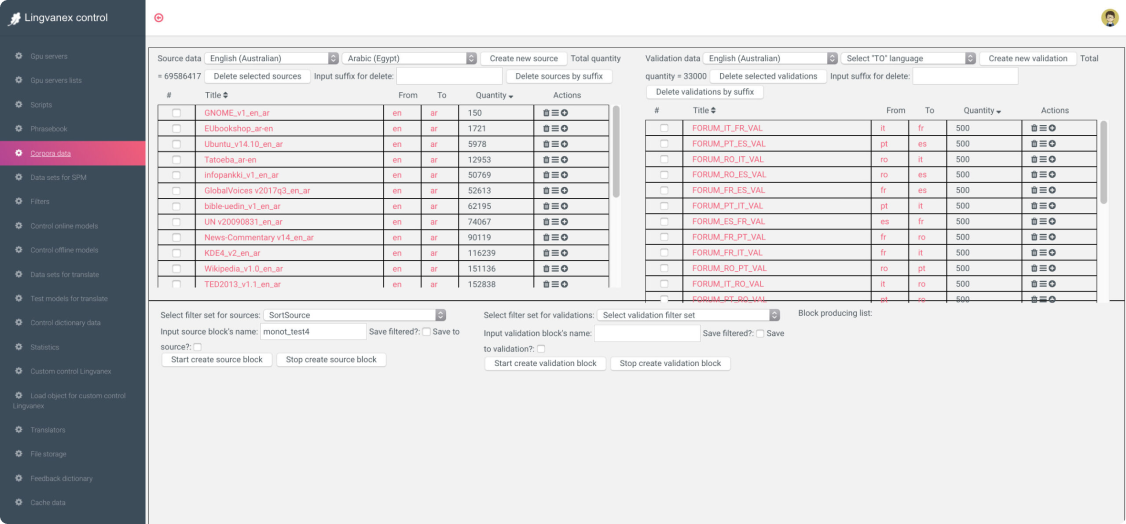

Bekerja dengan Data Paralel

Mengerjakan bahasa baru dimulai dengan persiapan dataset. Dasbor memiliki banyak set data yang telah ditentukan sebelumnya dari sumber terbuka seperti Wikipedia, Parlemen Eropa, Paracrawl, Tatoeba dan lain-lain. Untuk mencapai kualitas terjemahan rata-rata, 5 juta baris terjemahan sudah cukup.

Kamus dan Penyetelan Tokenizer

Dataset adalah baris-baris teks yang diterjemahkan dari satu bahasa ke bahasa lain. Kemudian tokenizer membagi teks ke dalam token dan membuat kamus dari mereka, diurutkan berdasarkan frekuensi pertemuan token. Token bisa berupa karakter tunggal, suku kata, atau seluruh kata. Dengan Lingvanex Data Studio Anda dapat mengontrol seluruh proses pembuatan kamus token SentencePiece untuk setiap bahasa secara terpisah.

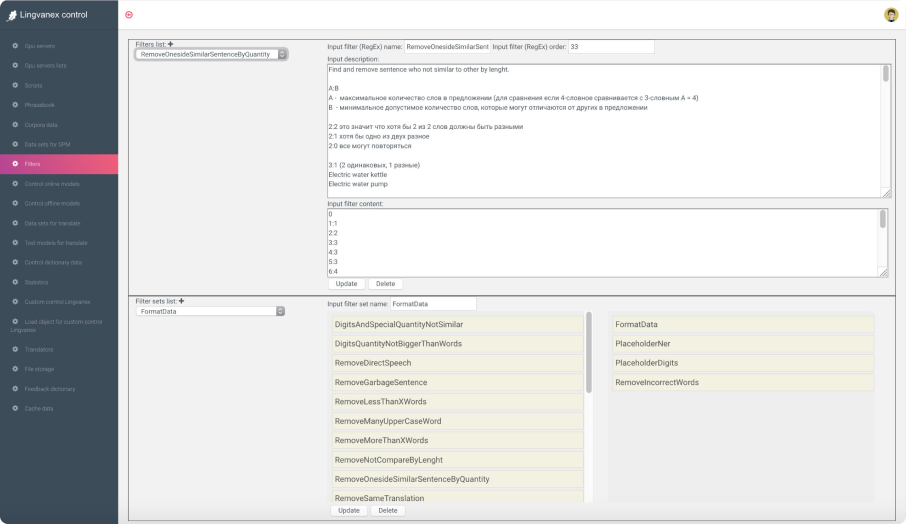

Penyaringan Data dan Estimasi Kualitas

Lebih dari 20 filter tersedia untuk memfilter korpora paralel dan monolingual untuk mendapatkan dataset berkualitas dari opensource atau data yang diurai. Anda dapat menandai entitas bernama, digit, dan token lainnya untuk melatih sistem agar beberapa kata tidak diterjemahkan atau diterjemahkan dengan cara tertentu.