Dans l’évaluation de la qualité des systèmes de traduction automatique, il est essentiel non seulement de comparer les résultats de différents systèmes, mais également de vérifier si les différences constatées sont statistiquement significatives. Cela permet de déterminer si les résultats obtenus sont valides et généralisables à d'autres données.

Dans cet article, nous passons en revue deux des métriques les plus courantes pour évaluer la qualité de la traduction, BLEU et COMET, et nous analysons comment tester la signification statistique des différences entre deux systèmes de traduction à l'aide de ces métriques.

Signification statistique de BLEU et COMET

La métrique BLEU (Bilingual Evaluation Understudy) évalue la qualité d'une traduction en comparant les n-grams d’un texte traduit avec ceux d’une traduction de référence (humaine). Selon l’étude « Yes, We Need Statistical Significance Testing », pour qu’une amélioration dans la métrique BLEU soit considérée comme statistiquement significative par rapport à un travail précédent, la différence doit être supérieure à 1,0 point BLEU. Si l'on considère une amélioration comme « hautement significative » avec un seuil de p-value < 0,001, la différence doit atteindre ou dépasser 2,0 points BLEU.

Une autre métrique largement utilisée, COMET (Crosslingual Optimised Metric for Evaluation of Translation), repose sur un modèle d’apprentissage automatique pour évaluer la qualité de la traduction par rapport à une traduction de référence. Les études montrent qu’une différence de 1 à 4 points dans la métrique COMET peut être statistiquement insignifiante, c’est-à-dire qu’elle peut se situer dans la marge d’erreur. Même une différence de 4,0 points COMET peut être jugée non significative.

Ces résultats ont des implications pratiques importantes pour les développeurs de systèmes de traduction automatique. Comparer uniquement les valeurs numériques peut mener à des conclusions trompeuses sur les améliorations de la qualité de traduction. Il est donc indispensable de réaliser des tests statistiques pour déterminer si les différences observées sont réellement significatives.

Choisir une métrique pour comparer les systèmes de traduction

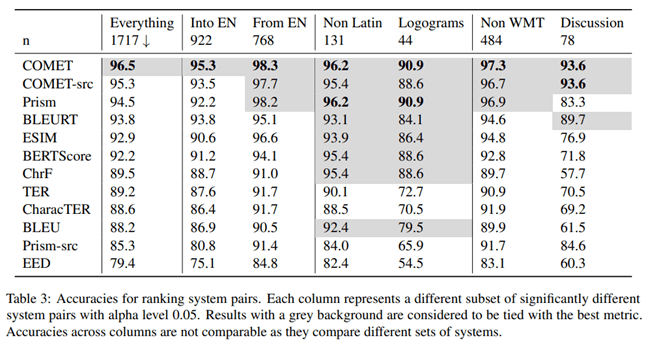

Dans l’article « To Ship or Not to Ship: An Extensive Evaluation of Automatic Metrics for Machine Translation », des chercheurs de Microsoft ont étudié quelle métrique d’évaluation de la qualité des traductions automatiques corrèle le mieux avec les évaluations réalisées par des traducteurs professionnels. Pour cela, ils ont mené l'expérience suivante:

Des traducteurs professionnels maîtrisant la langue cible ont d’abord traduit le texte manuellement sans post-édition, et un traducteur indépendant a confirmé la qualité de ces traductions. Les traducteurs avaient accès au contexte des autres phrases, mais traduisaient les phrases individuellement.

Selon les résultats de cette étude, la métr ique COMET, qui évalue les traductions en se basant sur une variante de référence, a montré la plus forte corrélation et la meilleure précision par rapport aux évaluations des traducteurs professionnels.

Les auteurs de l’article ont également examiné quelle métrique offrait la meilleure précision lors de la comparaison de la qualité de différents systèmes de traduction automatique. Selon leurs conclusions, COMET est la métrique la plus précise pour comparer des systèmes de traduction entre eux.

Pour tester la signification statistique des différences entre les résultats, les auteurs ont utilisé l’approche décrite dans l’article « Statistical Significance Tests for Machine Translation Evaluation ».

Il est évident que la métrique COMET est l’outil le plus fiable pour évaluer la qualité de la traduction automatique, que ce soit en la comparant à une traduction humaine ou en comparant différents systèmes de traduction entre eux. Cette conclusion est cruciale pour les développeurs de systèmes de traduction automatique, qui doivent évaluer et comparer objectivement les performances de leurs modèles.

Test de la signification statistique

Il est essentiel de s'assurer que les différences observées entre les systèmes de traduction sont statistiquement significatives, c’est-à-dire qu’il y a une forte probabilité qu’elles ne soient pas le fruit de facteurs aléatoires. À cette fin, Philipp Koehn propose d'utiliser la méthode du bootstrap dans son article « Statistical Significance Tests for Machine Translation Evaluation ».

La méthode de bootstrap est une procédure statistique basée sur l’échantillonnage avec remise pour déterminer la précision (biais) des estimations d'échantillons, telles que la variance, la moyenne, l’écart-type, les intervalles de confiance et d'autres caractéristiques structurelles d’un échantillon. Schématiquement, la méthode du bootstrap peut être décrite ainsi:

Un algorithme pour tester la signification statistique

Génération d’un échantillon bootstrap: un échantillon bootstrap de la même taille que l’échantillon initial est généré aléatoirement à partir de l’échantillon original. Certaines observations peuvent être sélectionnées plusieurs fois, tandis que d’autres peuvent ne pas être incluses.

Calcul de la moyenne: pour chaque échantillon bootstrap, la valeur moyenne d’une métrique (par exemple, BLEU ou COMET) est calculée.

Répétitions: la procédure d’échantillonnage bootstrap et de calcul des moyennes est répétée de nombreuses fois (dizaines, centaines ou milliers).

Calcul de la moyenne globale: une moyenne générale est calculée à partir de l’ensemble des moyennes obtenues, et cette moyenne est considérée comme la moyenne de l’échantillon entier.

Différence des moyennes: la différence entre les valeurs moyennes des systèmes comparés est calculée.

Construction d’un intervalle de confiance: un intervalle de confiance est établi pour la différence entre les moyennes.

Évaluation statistique: les critères statistiques sont utilisés pour déterminer si l’intervalle de confianc e montre que la différence entre les moyennes est significative.

Application pratique

L’approche décrite ci-dessus est mise en œuvre pour la métrique COMET dans la bib liothèque Unbabel/COMET. Cette bibliothèque, en plus de calculer la métrique COMET, permet de tester la signification statistique des résultats obtenus. Cette méthodologie représente une étape importante vers une évaluation plus fiable et valide des systèmes de traduction automatique. En effet, comparer uniquement les valeurs des métriques peut conduire à des conclusions erronées, surtout lorsque les différences sont minimes.

L’utilisation de méthodes d’analyse statistique, telles que le bootstrap, est essentielle pour évaluer objectivement et comparer les performances des systèmes de traduction automatique. Cela permet aux développeurs de prendre des décisions plus éclairées dans le choix des approches et des modèles, et d’offrir une présentation plus fiable des résultats aux utilisateurs.

Conclusion

Lors de la comparaison des systèmes de traduction automatique, il est crucial d’utiliser des méthodes statistiques pour distinguer les améliorations significatives des fluctuations aléatoires. Cela permet une évaluation plus objective des progrès réalisés dans la technologie de traduction automatique.