En la evaluación de la calidad de la traducción automática, es importante no sólo comparar los resultados de diferentes sistemas de traducción, sino también comprobar si las diferencias encontradas son estadísticamente significativas. Esto nos permite evaluar si los resultados obtenidos son válidos y pueden generalizarse a otros datos.

En este artículo, revisamos dos de las métricas más comunes para evaluar la calidad de la traducción, BLEU y COMET, y analizamos cómo probar la significación estadística de las diferencias entre dos sistemas de traducción utilizando estas métricas.

Importancia estadística de BLEU y COMET

La métrica BLEU (Subestudio de Evaluación Bilingüe) evalúa la calidad de la traducción comparando los n-gramas en un texto traducido con los n-gramas en una traducción de referencia (humana). Según el estudio “Sí, necesitamos pruebas de importancia estadística”, para afirmar una mejora estadísticamente significativa en la métrica BLEU con respecto a trabajos anteriores, la diferencia debe ser mayor que 1,0 puntuación BLEU. Si consideramos una mejora “altamente significativa como ” p-valor “0,001<, la mejora debe ser de 2,0 puntos BLEU o más.

Otra métrica ampliamente utilizada, COMET (Métrica cruzada optimizada para la evaluación de la traducción), utiliza un modelo de aprendizaje automático para evaluar la calidad de la traducción en comparación con una traducción de referencia. El estudio demostró que una diferencia de 1 a 4 puntos puede ser estadísticamente insignificante, es decir, dentro del margen de error. Incluso una diferencia de 4,0 puntuaciones COMET puede ser insignificante.

Estos resultados tienen importantes implicaciones prácticas para los desarrolladores de sistemas de traducción automática. La simple comparación de métricas numéricas puede llevar a conclusiones engañosas sobre las mejoras en la calidad de la traducción. En cambio, se deben realizar pruebas estadísticas para determinar si las diferencias observadas son realmente significativas.

Selección de una métrica para comparar sistemas de traducción

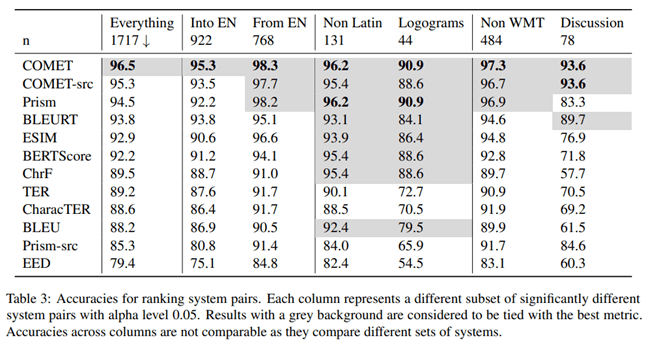

En el artículo “Enviar o no enviar: una evaluación exhaustiva de métricas automáticas para traducción automática”, investigadores de Microsoft investigaron qué métrica para evaluar la calidad de la traducción automática se correlaciona mejor con la evaluación de traductores profesionales. Para ello, realizaron el siguiente experimento.

Los traductores profesionales competentes en el idioma de destino primero tradujeron el texto manualmente sin posedición y luego un traductor independiente confirmó la calidad de estas traducciones. Los traductores vieron el contexto de otras oraciones, pero las tradujeron por separado.

Según los resultados de este estudio, la métrica COMET, que evalúa la traducción basándose en una variante de referencia, mostró la mayor correlación y precisión en comparación con las evaluaciones de traductores profesionales.

Los autores del artículo también estudiaron qué métrica proporciona la mayor precisión al comparar la calidad de diferentes sistemas de traducción automática. Según sus hallazgos, COMET es la métrica más precisa para comparar sistemas de traducción entre sí.

Para probar la significación estadística de las diferencias entre los resultados, los autores utilizaron el enfoque descrito en el artículo “Pruebas de significancia estadística para la evaluación de traducción automática”.

Está claro que la métrica COMET es la herramienta más fiable para evaluar la calidad de la traducción automática, tanto cuando se compara con la traducción humana como cuando se comparan diferentes sistemas de traducción entre sí. La conclusión es importante para los desarrolladores de sistemas de traducción automática que necesitan evaluar y comparar objetivamente el rendimiento de sus modelos.

Pruebas de importancia estadística

Es importante asegurarse de que las diferencias observadas entre los sistemas de traducción sean estadísticamente significativas, es decir, con una alta probabilidad de que no sean el resultado de factores aleatorios. Para ello, Philipp Koehn sugiere utilizar el método bootstrap en el suyo artículo “Pruebas de importancia estadística para la evaluación de la traducción automática”.

El método de remuestreo bootstrap es un procedimiento estadístico basado en muestreo con reemplazo para determinar la precisión (sesgo) de las estimaciones muestrales de varianza, media, desviación estándar, intervalos de confianza y otras características estructurales de una muestra. Esquemáticamente, el método bootstrap se puede representar de la siguiente manera:

Un algoritmo para probar la significación estadística:

1. Se genera aleatoriamente una muestra de arranque del mismo tamaño a partir de la muestra original, donde algunas observaciones pueden capturarse varias veces y otras pueden no capturarse en absoluto.

2. Para cada muestra de arranque, se calcula el valor medio de una métrica (p. ej., BLEU o COMET).

3. El procedimiento de muestreo bootstrap y cálculo de promedios se repite muchas veces (decenas, cientos o miles).

4. A partir del conjunto de promedios obtenido se calcula el promedio global, que se considera el promedio de toda la muestra.

5. Se calcula la diferencia entre los valores medios de los sistemas comparados.

6. Se construye un intervalo de confianza para la diferencia entre los promedios.

7. Los criterios estadísticos se utilizan para evaluar si el intervalo de confianza para la diferencia de promedios es estadísticamente significativo.

Aplicación práctica

El enfoque descrito anteriormente se implementa para la métrica COMET en la biblioteca Unbabel/COMET, que, además de calcular la métrica COMET, también proporciona la capacidad de probar la significación estadística de los resultados obtenidos. Este enfoque es un paso importante hacia una evaluación más confiable y válida de los sistemas de traducción automática. Simplemente comparar métricas a menudo puede resultar engañoso, especialmente cuando las diferencias son pequeñas.

La aplicación de métodos de análisis estadístico como el bootstrap es un paso importante para evaluar y comparar objetivamente el rendimiento de los sistemas de traducción automática. Esto permite a los desarrolladores tomar decisiones más informadas al seleccionar enfoques y modelos óptimos y proporciona una presentación más confiable de los resultados a los usuarios.

Conclusión

Por lo tanto, al comparar sistemas de traducción automática, es importante utilizar métodos estadísticos para separar las mejoras significativas de los factores aleatorios. Esto dará una evaluación más objetiva del progreso de la tecnología de traducción automática.